Kora słuchowa: fizjologia

Anatomiczne i funkcjonalne cechy ludzkiej kory słuchowej są bardzo złożone i wciąż pozostaje wiele pytań dotyczących integracji informacji słuchowych na tym poziomie.

Historia

Pierwsze badania łączące strukturę i funkcję kory mózgowej płata skroniowego z percepcją słuchową i przemówienie wygłosili Paul Broca (1824-1880) i Carl Wernicke (1848-1904). Opisy afazji Broki (zaburzenia mowy spowodowane przez uszkodzenie w obszarach Brodmana 44 i 45 – obecnie również znane jako obszar Broki) i afazji Wernickego (zaburzenie percepcji mowy spowodowane uszkodzeniem obszaru Brodmana 22) umożliwiło określenie lokalizacji słuchu i przetwarzania mowy w korze mózgowej.

Funkcja kory słuchowej

Klasycznie, w korze słuchowej opisano dwa główne obszary funkcjonalne:

- Pierwotna kora słuchowa (AI), złożona z neuronów biorących udział w dekodowaniu ślimakowej i tonotopowej reprezentacji przestrzennej bodźca.

- Wtórna kora słuchowa (AII), która nie mają wyraźną organizację tonotopową, ale odgrywają ważną rolę w lokalizacji dźwięku i analizie złożonych dźwięków: w szczególności w przypadku specyficznych odgłosów zwierząt i języka ludzkiego. Odgrywa również rolę w pamięci słuchowej.

- Obszar pasa otaczający sztuczną inteligencję i AII, który pomaga zintegrować słuch z innymi systemami sensorycznymi.

Funkcja podstawowego słuchu kora

W sztucznej inteligencji neurony są selektywne dla określonych częstotliwości i są ułożone w pasmach iz częstotliwości, które są uporządkowane tonotopowo. Dokładne przestrzenne rozmieszczenie pasm izoczęstotliwości jest związane z organizacją receptorów słuchowych. Ich aktywność zależy od właściwości bodźca: częstotliwości, natężenia i położenia źródła dźwięku w przestrzeni. Funkcjonalnie na ten region silnie wpływa stan przebudzenia badanego. Szereg bardzo specyficznych neuronów w sztucznej inteligencji jest również zaangażowanych w analizę złożonych dźwięków.

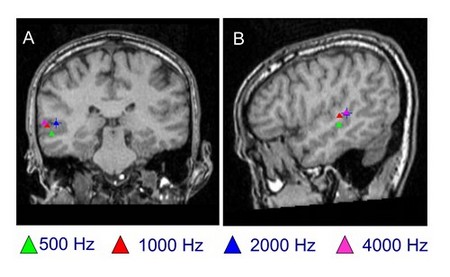

Nowe techniki badania kory mózgowej (obrazowanie funkcjonalnego rezonansu magnetycznego: fMRI; pozytonowa tomografia emisyjna: PET; i magnetoencefalografia: MEG ) sugerują, że rozkład częstości obserwowany u zwierząt (przy zastosowaniu tradycyjnych metod doświadczalnych) nie odpowiada dokładnie rozkładowi obserwowanemu u ludzi, chociaż wszystkie mają pasma izoczęstotliwości, jak pokazano przy użyciu MEG poniżej. fMRI u ludzi sugeruje, że niskie częstotliwości są kodowane w powierzchownych tylno-bocznych obszarach szczeliny Sylwiusza, podczas gdy wysokie częstotliwości są zlokalizowane w obszarach głębszych i przednio-przyśrodkowych. Należy jednak zauważyć, że istnieje pewien stopień zróżnicowania między osobami.

|

Magnetoencefalografia (MEG): lokalizacja czystych tonów u osoby normalnie słyszącej Lokalizacja czystych tonów (500 Hz, 1000 Hz, 2000 Hz i 4000 Hz) z przodu Płaszczyzny (A) i boczne (B). Zdjęcie P. Gil-Loyzaga, Centre MEG de l „Université Complutense (Madryt). |

Czasowa integracja bodźców słuchowych

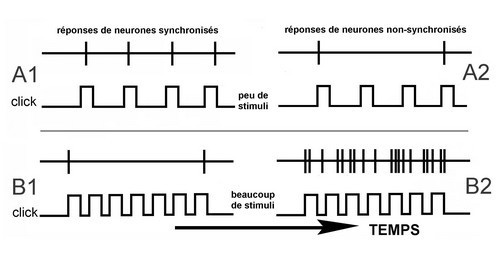

Po przebudzeniu ludzie, podobnie jak inne zwierzęta, są w stanie dostrzec małe czasowe zmiany złożonych dźwięków. wariacje są niezbędne do zrozumienia mowy ludzkiej. W szeregu badań poświęconych AI stwierdzono, że u przytomnych naczelnych dwie odrębne populacje (odpowiednio) synchronicznych i asynchronicznych neuronów kodują sekwencję inne bodźce.

- Synchroniczne neurony analizują powolne zmiany czasowe. Reagują precyzyjnie na stymulację niską częstotliwością (A1), ale nie są w stanie utrzymać swojej aktywności przy wzroście liczby bodźców. Szybkie zmiany tempa są postrzegane przez te neurony jako ciągły ton. Są zaangażowani zarówno w analizę częstotliwości, jak i intensywności.

- Asynchroniczne neurony analizują szybkie zmiany czasowe (wielu bodźców). Potrafią określić krótkotrwałe zmiany i dokładnie odróżnić jeden bodziec od drugiego.

Funkcjonalny podział kory słuchowej umożliwia bardzo dokładne odkodowanie czasowych zmian bodźca w porównaniu z innymi ośrodkami ścieżki słuchowej. Pozwala uzyskać więcej informacji o złożonych dźwiękach, a także o lokalizacji źródła dźwięku i jego ruchu.

Rysunek: Odpowiedzi synchronizacja neuronów – > Odpowiedzi w komórkach synchronicznych

Odpowiedzi w przypadku braku synchronizacji neuronów – > Odpowiedzi w komórki asynchroniczne

Peu de stimuli – > kilka bodźców

Beaucoup de stimuli – > wiele bodźców

Temps – > Czas

Synchroniczne i asynchroniczne neurony

- Synchroniczne neurony zawsze reaguj na każdy bodziec (klik), gdy ciągi bodźców mają odstępy większe niż 20 ms (A1). W miarę zmniejszania się interwału międzytrenowego (tj. Szybkości powtarzania stają się szybsze), neurony te zaczynają desychronizować szybkość ich odpalania. Kiedy interwał między bodźcami spada poniżej 10 ms (B1), neurony te wysyłają impuls tylko na początku i na końcu bodźca (odpowiednio odpowiedzi początku i przesunięcia).

- Asynchroniczne neurony nie odpowiadają synchronicznie na bodźce ( A2 i B2), ale ich aktywność wzrasta stopniowo do bardzo wysokiego współczynnika rozładowania (B2).

Widmowa integracja bodźców słuchowych

Głosy zwierząt i język ludzki znacznie się różnią między osobami. W ramach tego samego przedmiotu istnieją również dobrowolne i mimowolne różnice. Chociaż percepcja komunikatów słuchowych wymaga analizy częstotliwości składających się na złożony dźwięk, analiza widmowa jest jeszcze ważniejsza.

Jeśli widmo dźwiękowe zawierające cały profil fali dźwiękowej złożonego dźwięku (obwiednia dźwięku) jest zachowana, może dojść do dobrego słuchu i rozumienia fonemów, nawet po usunięciu pewnych określonych częstotliwości.

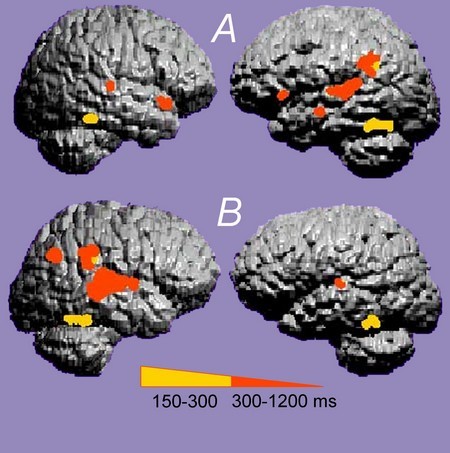

Nieinwazyjne obrazowanie MEG może być wykorzystane do dokładnego określenia z doskonałą przestrzenną precyzją lokalizacji wywołanej aktywności, która występuje w kilka milisekund. MEG to odpowiednia technika do badania złożonych funkcji słuchowych, takich jak mowa, a także potencjalnych skutków czynnościowych uszkodzeń kory mózgowej.

|

MEG u osoby normalnej (A) i osoby z dysleksją (B) U osób normalnie słyszących (A), specyficzna językowa aktywacja kory występuje głównie w lewej korze słuchowej. U osób z dysleksją (B) aktywacja jest bardziej widoczna w prawej korze mózgowej i jest bardziej rozproszona. Zdjęcie P. Gil-Loyzaga, Centre MEG de l „Université Complutense (Madryt) |